AI組織マネジメントの教科書:リーダーが知っておくべき運用とリスク管理の実践ガイド

AI組織マネジメントの教科書:リーダーが知っておくべき運用とリスク管理

生成AIや機械学習の実用化が一気に進み、「AIをどう導入するか」から「AIをどうマネジメントするか」が経営・組織にとっての主要テーマになりつつあります。

本記事では、経営者・事業責任者・部門マネージャーなどのリーダーに向けて、AI組織マネジメントの基本と実務的な運用・リスク管理のポイントを体系的に整理します。

技術的な詳細よりも、組織設計・意思決定・ガバナンスに焦点を当て、「明日から自社で何を決め、どこから着手すべきか」が分かる実践的な内容を目指します。

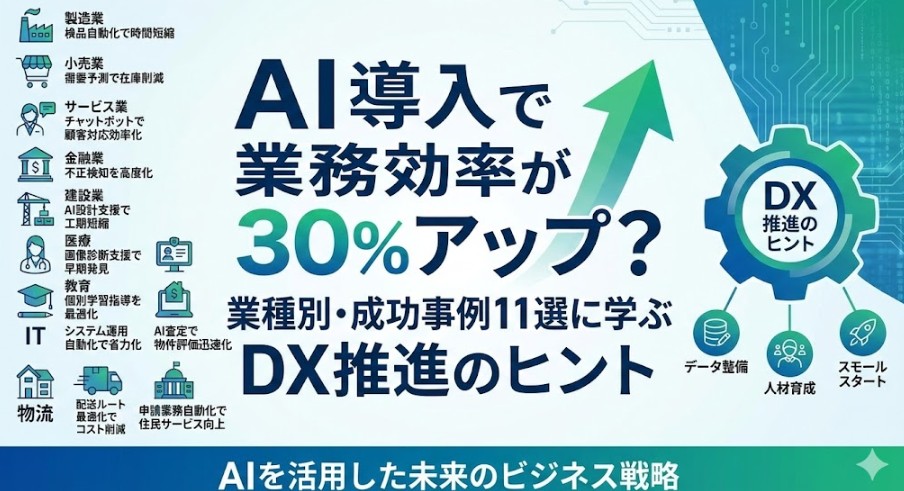

1. なぜ今「AI組織マネジメント」が重要なのか

1-1. 「AIを入れるか」ではなく「どう使いこなすか」の時代

これまで多くの企業では、「AIツールを導入するか・しないか」が議論の中心でした。しかし生成AIの普及によって、個人レベルでのAI利用は既に当たり前になりつつあります。社員が個人でChatGPTや画像生成AIを使い、業務の一部を効率化しているケースは珍しくありません。

ここで経営やマネジメントに求められるのは、「AIを禁止するか黙認するか」ではなく、「どの範囲・どのルールで活用するか」を設計し、組織としての生産性とリスクのバランスを取ることです。

1-2. AI活用は「個人のスキル」から「組織能力」へ

生成AIを使いこなす個人が増えるほど、企業間の差は「ツールの有無」ではなく、AIを前提にした業務設計・評価制度・権限設計・ガバナンスの差になっていきます。つまり、AIはもはやIT部門だけのテーマではなく、組織能力そのものを再設計するトリガーです。

その意味で「AI組織マネジメント」とは、単にAIプロジェクトを管理することではなく、AI時代にふさわしい組織のルール・役割・責任の再定義とも言えます。

2. AI組織マネジメントの3つの柱

AIを組織として運用する際、リーダーが押さえておくべき重要な観点は次の3つです。

- ① 戦略とガバナンス:何のために、どの領域でAIを使うかを明確にする

- ② 業務設計と運用プロセス:AIを前提とした仕事の流れと責任分担を定義する

- ③ リスク管理とコンプライアンス:法的・倫理的リスクを評価し、回避・低減策を講じる

以下、それぞれをもう少し具体的に解説していきます。

3. 戦略とガバナンス:AI活用の目的とルールを定義する

3-1. 「DXの一部」ではなく「事業戦略の一部」として位置付ける

AI活用がうまくいかない組織の典型例は、AIをIT施策やDXプロジェクトとして切り出し、事業戦略と切り離してしまうことです。

AI組織マネジメントでは、まず次の3つを明確にすることが出発点となります。

- どの事業・サービスのどの価値提供を高めたいのか

- そのために、AIに何を任せて/何を人間が担うのか

- 成果を測るためのKPIや評価指標は何か

AI導入の目的が「生産性向上なのか」「新規価値創造なのか」「リスク削減なのか」で、必要な体制・投資・ガバナンスは大きく変わります。

3-2. 全社AIポリシーと部門ルールを階層的に設計する

AIガバナンスを構築するうえで重要なのは、「全社共通のAIポリシー」と「部門ごとの運用ルール」を分けて設計することです。

例として、次のような階層構造が考えられます。

(1)全社AIポリシー(トップが責任を持つレベル)

- 機密情報や個人情報を外部AIサービスに入力しないという原則

- AIが生成した成果物の最終責任は人間が負うという立場

- AI活用における差別・偏見・人権侵害の禁止

- 自社ブランドを守るための品質基準や倫理基準

(2)部門・職種別ガイドライン(現場マネージャーが設計するレベル)

- 営業部での提案書作成におけるAIの使用範囲と禁止事項

- マーケティング部でのコピー生成におけるチェックプロセス

- 開発部門でのコード生成AI利用時のレビュー体制

このように全社ポリシーで「守るべき最低ライン」を定めつつ、各部門のマネージャーが自部門に最適化した運用ルールを整えることが、実効性のあるAI組織マネジメントにつながります。

4. 業務設計と運用プロセス:AIを前提とした仕事の再構築

4-1. 「AIに何を任せるか」をタスク分解で明確にする

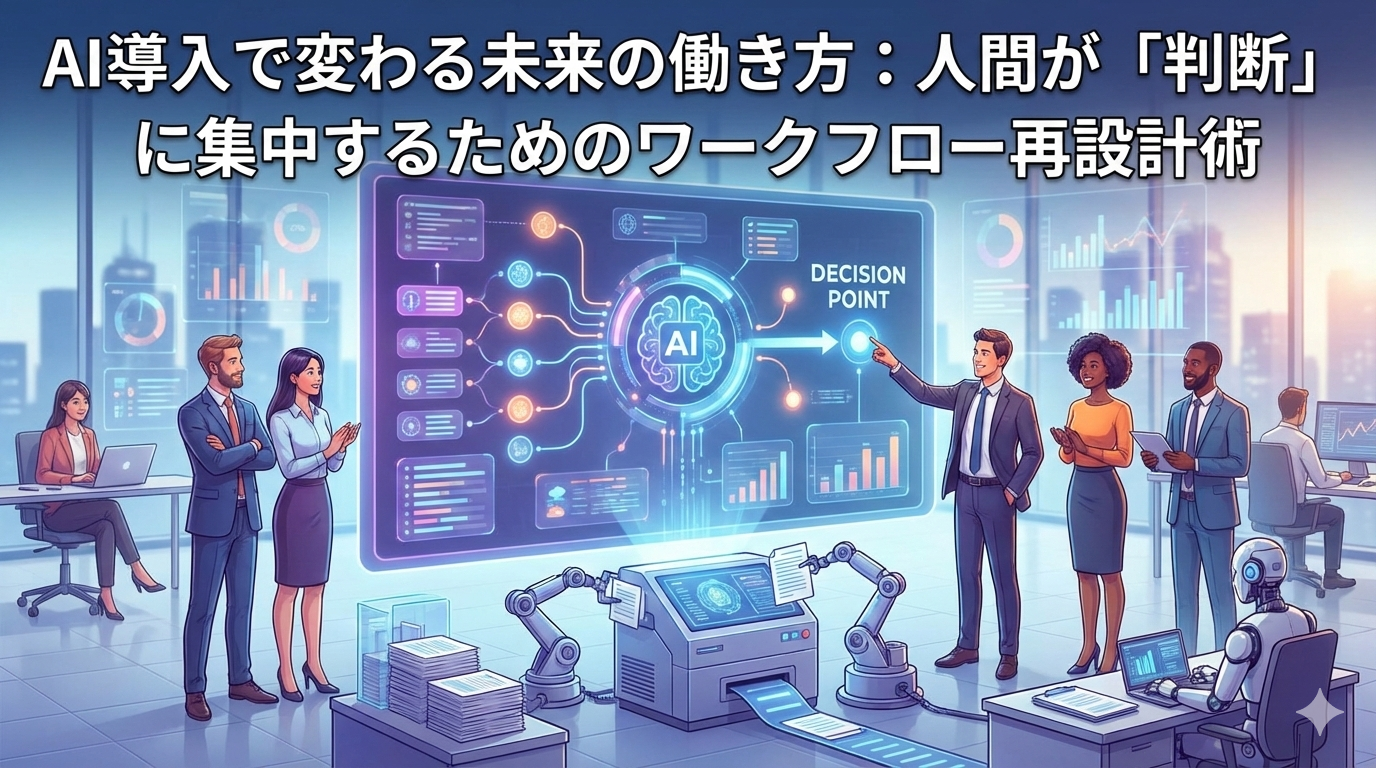

AI活用の効果は、「AIに向いているタスク」と「人間にしかできないタスク」をどれだけ切り分けられるかによって変わります。まずは既存業務をタスクレベルに分解し、次のように分類してみましょう。

- A:AIにほぼ任せられる作業

例:文書の下書き、定型メール作成、ログの一次解析など - B:AIと人間の協働が望ましい作業

例:企画案のアイデア出し、コードの生成とレビュー、レポートの構成案作りなど - C:人間が主導すべき作業

例:意思決定、重要な交渉、倫理的判断、最終レビューなど

AI組織マネジメントにおいてリーダーが担うべきは、この「A〜C」の線引きを組織として定義し、メンバーに明示することです。曖昧なまま現場に任せてしまうと、品質事故や責任の所在の不明確さにつながります。

4-2. 「AI+人間」の標準フローを決める

タスク分解の次に重要なのが、AIの活用を前提にした標準的な業務フローを設計することです。例えば、マーケティングのコンテンツ制作なら、次のようなフローが考えられます。

- 担当者がAIに対して企画の方向性や条件を指示(プロンプト)

- AIが原案を生成

- 担当者が内容を精査し、修正・加筆

- 法務・ブランド担当者がチェック(必要に応じて)

- 上長が最終承認

このようにプロセスを明文化し、どの段階で誰が何をチェックするのかを定めることで、AIによる業務効率化と品質担保を両立しやすくなります。

4-3. AIスキルは「全員最低限+一部専門化」で設計する

AI組織マネジメントでは、人材育成も重要なテーマです。理想は、次のような二層構造を作ることです。

- 全社員レベル:自分の業務で生成AIを安全かつ効果的に使える基礎スキル

- AIリーダー・AIチャンピオン層:各部門に配置し、活用の相談役・教育役・ルール策定の窓口として機能

全員に高度なAI技術を求める必要はありませんが、最低限のリテラシーを全社で揃えつつ、一部の人材を「AI推進ハブ」として育成することが、組織としてのAI活用レベルを底上げする近道です。

5. リスク管理とコンプライアンス:AI運用の落とし穴と対策

5-1. AI組織マネジメントにおける主なリスク

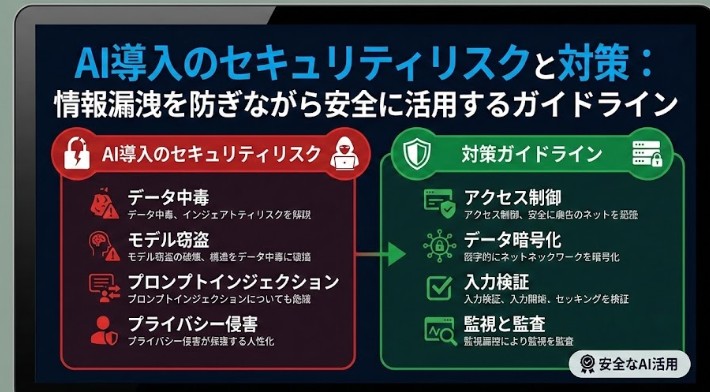

AIを組織的に運用する際に想定すべき主なリスクは、次の4つに整理できます。

- ① 情報漏洩リスク

機密情報や個人情報を外部AIに入力することで、情報が学習に利用されたり第三者に参照される可能性。 - ② 法務・コンプライアンスリスク

著作権侵害、商標権侵害、プライバシー侵害など、AIが生成したコンテンツの利用に伴う法的リスク。 - ③ 品質・信頼性リスク

AIの誤った回答(ハルシネーション)や、偏ったデータに基づく判断により、顧客や社会に損害を与えるリスク。 - ④ 倫理・レピュテーションリスク

差別的・攻撃的な表現、不適切な画像生成などによるブランド毀損や社会的批判。

5-2. リスク管理の基本原則:完全回避ではなく「許容可能なコントロール」へ

AIリスク管理でありがちな誤りが、リスクを恐れるあまり「全面禁止」に近いルールを作ってしまうことです。これでは、競合他社との差が広がる一方です。

重要なのは、リスクをゼロにすることではなく、「許容可能な範囲にコントロールする」ことです。そのために、次のような考え方が有効です。

- 高リスクな用途(顧客への法的アドバイス、個人データの大量処理など)は、専門部署の承認制にする

- 中リスクな用途(対外的に公開されるコンテンツなど)は、レビューとログ管理を徹底する

- 低リスクな用途(社内向け資料のたたき台作成など)は、ルールを定めて原則自由とする

このように、用途ごとにリスクレベルと必要な管理レベルを整理することが、現実的で使えるAIリスク管理のポイントです。

5-3. 具体的な運用ルールの例

AI組織マネジメントの一環として、次のような実務的ルールを整備しておくと効果的です。

- 入力データに関するルール

・機密情報・個人情報・取引先名などは原則入力禁止

・やむを得ない場合は、匿名化・マスキングを徹底 - 出力結果に対するルール

・AIが生成したコンテンツは必ず人間がチェックし、事実確認を行う

・外部公開物には「AIを使用して作成した」ことを明示するかどうかの方針を決める - ログとトレーサビリティ

・重要な判断にAIを活用した場合、そのプロセスと理由を記録しておく

・後から説明できる状態(Explainability)を意識する

6. AI運用体制の作り方:責任と役割を明確にする

6-1. AI推進委員会・ワーキンググループの設置

ある程度の規模の組織では、AI活用を現場任せにするのではなく、横断的な推進体制を作ることが有効です。代表的なのが、次のような体制です。

- 経営層:AI戦略の方向性と投資判断を行う

- AI推進委員会:全社ポリシー・ガバナンスの設計、優先プロジェクトの選定

- 現場部門のAIリーダー:部門内での活用推進、課題の吸い上げ、教育

- 情報システム部門・法務・人事:セキュリティ・契約・評価制度などの整備

こうした体制を通じて、「トップダウンの方針」と「ボトムアップの現場ニーズ」を接続することが、AI組織マネジメントにおける鍵となります。

6-2. 小さく始めて学習する「パイロットプロジェクト」

AI導入においては、最初から全社展開を狙うのではなく、限定した領域でパイロットプロジェクトを実施し、そこで得られた知見を横展開するやり方が有効です。

パイロット候補としては、次のような条件を満たす業務が適しています。

- 定型的なプロセスが多く、AIによる効率化の余地が大きい

- 成果が数値で測りやすい(時間削減、コスト削減など)

- 失敗してもクリティカルなダメージが少ない

パイロットを通じて、どのような教育が必要か、どんなリスクが顕在化するか、どのルールが現実的かを検証し、その結果をもとに全社ポリシーやマニュアルをブラッシュアップしていきます。

7. AI時代のリーダーシップ:マネージャーは何を変えるべきか

7-1. 「指示するリーダー」から「設計するリーダー」へ

AI組織マネジメントの文脈では、リーダーの役割も変わります。従来は、マネージャー自身が判断し、部下に具体的な指示を出すスタイルが一般的でした。しかしAI活用が進むと、リーダーは次のような役割をより強く求められます。

- AIと人間の役割分担を設計する

- メンバーが安心してAIを使えるルールと環境を整える

- 成果物そのものよりも、プロセスと判断基準をレビューする

つまり、リーダーは「自ら何でもやる人」から「仕組みと環境をデザインする人」へとシフトしていく必要があります。

7-2. 評価と報酬の考え方もアップデートする

AI活用が進むと、「どれだけの量をこなしたか」ではなく、「AIを活かしてどれだけ付加価値を生み出したか」が評価の基準になっていきます。

例えば、同じ成果物を作るのに、AさんはAIを活用して1時間で、BさんはAIを使わずに5時間かけて作ったとします。このとき、従来の「努力や時間」を重視する評価軸のままだと、Bさんの方が「頑張った」と評価されかねません。しかし、組織全体の生産性向上という観点からは、AIを使いこなして短時間で成果を出したAさんを評価すべきです。

AI組織マネジメントにおける評価制度では、次のような観点を取り入れることが重要です。

- AIを適切に活用し、成果の質とスピードを高めているか

- AI活用のノウハウをチームに共有しているか

- AIに任せるべきでない領域を見極め、人間としての判断力・倫理観を発揮しているか

8. まとめ:AI組織マネジメントは「一度決めて終わり」ではない

AI技術と法規制の変化は非常に速く、今日のベストプラクティスが1年後には陳腐化している可能性もあります。そのため、AI組織マネジメントは「一度ルールを作れば終わり」ではなく、継続的に見直し・学習していくプロセスと捉えることが重要です。

最後に、本記事で紹介したポイントを簡単に整理します。

- AIは「導入するか否か」の議論から、「どうマネジメントするか」の段階へ

- 戦略・業務設計・リスク管理の3つを軸に、AI組織マネジメントを考える

- 全社AIポリシーと部門別ルールを階層的に整備する

- 業務をタスク分解し、AIと人間の役割分担を明確にする

- リスクはゼロにするのではなく、用途ごとに許容範囲をコントロールする

- AI推進体制を整え、パイロットプロジェクトで学習しながら全社展開する

- リーダーは「指示する人」から「環境と仕組みを設計する人」へと変化する

AI組織マネジメントに「正解」はありませんが、自社なりの方針と運用ルールを持っているかどうかが、今後の競争力を大きく左右します。本記事を参考に、自社にとって最適なAI運用とリスク管理のあり方を、ぜひ具体的に設計してみてください。

ブログ一覧へ戻る

ブログ一覧へ戻る

LINEで無料相談

LINEで無料相談 お問い合わせ

お問い合わせ