AI組織のリスク管理術:セキュリティと倫理を両立させながらイノベーションを加速させる実践戦略

AI組織のリスク管理術:セキュリティと倫理を両立させながらイノベーションを加速させる実践戦略

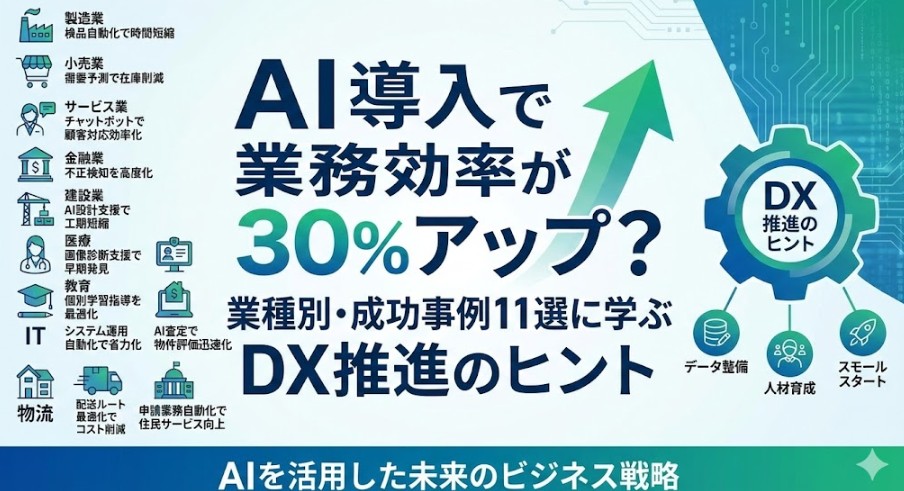

生成AIや機械学習がビジネスの中核になりつつある今、「AIをどれだけ早く導入するか」だけでなく、「どれだけ安全かつ倫理的に活用できるか」が、企業競争力を大きく左右します。

一方で、セキュリティや倫理に配慮しすぎると、社内での検証が進まず、イノベーションが鈍化してしまうというジレンマもあります。

この記事では、AI組織のリスク管理術として、セキュリティと倫理を両立させながら、イノベーションを加速させるための具体的な考え方と実践ステップを整理します。AI導入を検討している企業の経営層・DX担当者・情報システム部門・AI開発チームの方に向けて、すぐに使えるフレームワークとポイントを解説します。

1. なぜ今「AIリスク管理」が重要なのか

1-1. AIの価値は「スピード」だけではない

ChatGPTをはじめとする生成AIの登場で、社内のPoC(概念実証)や業務改善にAIを活用する企業が急増しています。しかし、スピードだけを重視した導入は、以下のような深刻なリスクを生みます。

- 機密情報の外部サービスへの入力による情報漏えいリスク

- AIが誤った情報(ハルシネーション)を出力し、そのまま意思決定に使われるリスク

- 著作権侵害や差別・偏見を助長するコンテンツ生成による法的・レピュテーションリスク

- データガバナンスが追いつかず、後から統制不能になるリスク

これらの問題は、一度発生すると信頼の失墜や事業継続へのダメージに直結します。そのため、AI導入を「攻め」だけでなく、「守り」も含めた総合戦略として設計することが不可欠です。

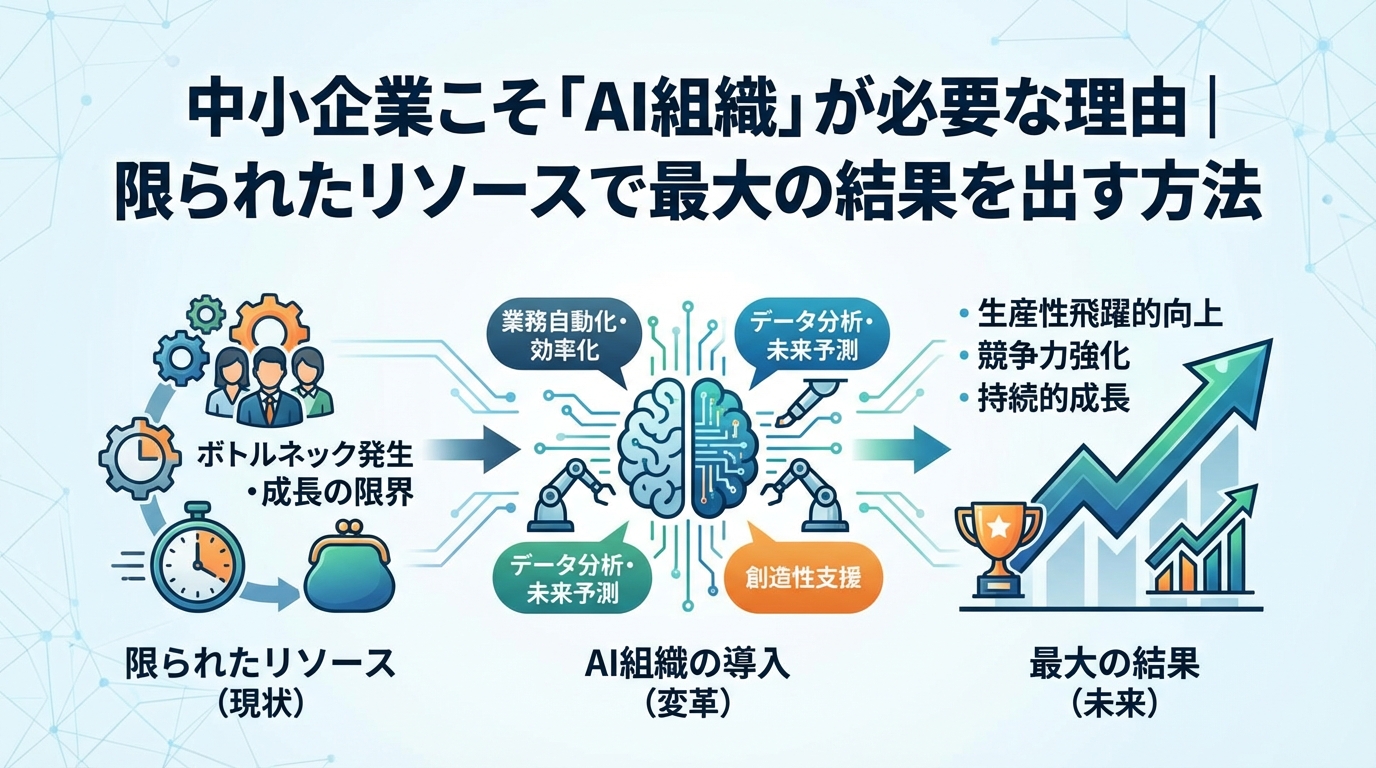

1-2. 「止めるリスク」と「やりすぎるリスク」

AI組織のリスク管理で見落とされがちなのが、AIを止めること自体もリスクであるという視点です。

- AIを止めるリスク: 競合がAIを活用して生産性や付加価値を高める中、自社だけが旧来のプロセスにとどまり、コストや時間で劣後してしまう。

- AIをやりすぎるリスク: 十分なセキュリティ・倫理基準を整えないまま全面展開し、事故・炎上・コンプライアンス違反を引き起こす。

AIのリスク管理とは、この2つのリスクのバランスを取りながら、最適なスピードで安全に前進するための仕組みづくりだと捉えると分かりやすくなります。

2. AI組織が直面する主なリスク領域

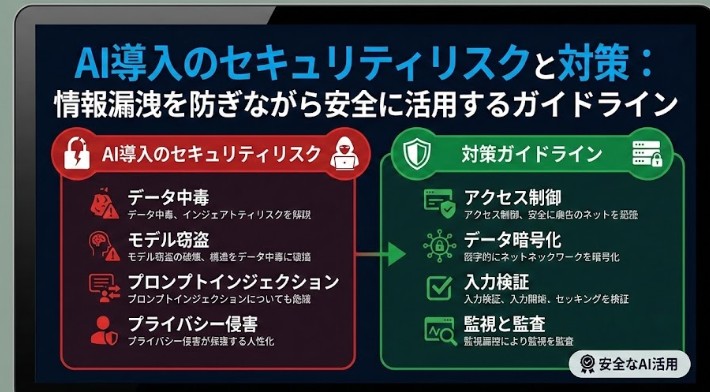

具体的な対策に入る前に、AI組織が押さえておくべき主なリスク領域を整理します。

2-1. 情報セキュリティとプライバシー

AIシステムでは、通常の業務システムよりも多様で大量なデータを扱います。特に生成AIでは、ユーザーが入力するプロンプトに機密情報や個人情報が含まれやすいという特徴があります。

代表的なリスクは次の通りです。

- 外部のAIサービスに対する機密情報・個人情報の誤入力

- 十分に匿名化されていない学習データによるプライバシー侵害

- モデルからの機密情報の逆推定(モデルインバージョン攻撃)

- API・クラウド環境の設定不備による不正アクセス

2-2. 倫理・法務・コンプライアンス

AIは、入力データや学習データのバイアスを増幅しやすく、差別的・攻撃的・不適切な出力を生成する可能性があります。また、著作権保護コンテンツを無断で学習・生成することによる法的リスクも無視できません。

- 差別的・侮辱的表現を含むコンテンツ生成

- 特定個人・属性に対する不公平な意思決定の支援

- 著作権侵害・商標権侵害・パブリシティ権侵害

- AIが生成したコンテンツの責任範囲の不明確さ

2-3. 品質・信頼性・説明責任

AIの出力は確率的であり、人間にとって「もっともらしく見える誤り」を含んでいることがあります。これはいわゆるハルシネーション問題であり、特に以下のような場面で深刻になります。

- 医療・金融・公共政策など高リスク分野での意思決定支援

- 顧客向けFAQやチャットボットにおける誤案内

- レポート・契約書・技術文書などの自動生成

説明責任(アカウンタビリティ)の観点からも、AIの出力をどの程度信頼し、誰が最終的な判断を行うのかを明確にしておく必要があります。

2-4. 組織・ガバナンス・文化

AI導入は技術の問題だけでなく、組織と文化の変革を伴います。

- 部門ごとにバラバラにAIツールを導入し、統制が効かなくなる「シャドーAI」問題

- 現場がAIを「監視・査定の道具」と捉え、反発や萎縮が起きる

- 経営層と現場のAIリテラシーギャップによる意思疎通の断絶

こうした組織面のリスクを放置すると、せっかくのAI投資が分散し、全社最適ではなく部分最適にとどまる危険があります。

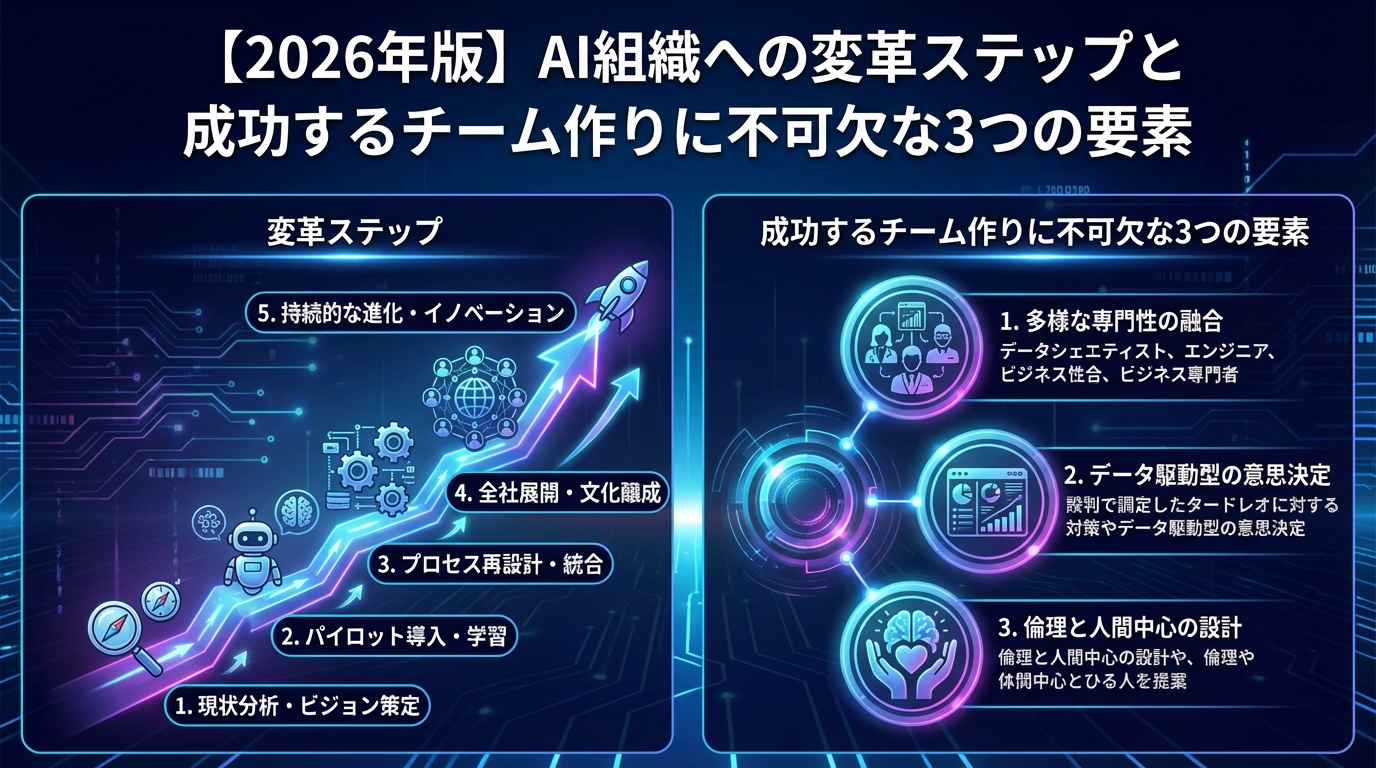

3. セキュリティと倫理を両立させる「AIガバナンス」の基本設計

AI組織のリスク管理を実現するには、技術的な対策だけでなく、全社的なAIガバナンスの枠組みを用意することが重要です。ここでは、導入の初期段階から中期までに整えておきたい基本設計を紹介します。

3-1. AIポリシーと利用ルールを明文化する

まず取り組むべきは、AI利用に関する基本方針(AIポリシー)の策定です。少なくとも、以下の観点を盛り込むとよいでしょう。

- AI活用の目的と、企業としてのスタンス(何を目指し、何をしないか)

- 機密情報・個人情報を外部AIサービスに入力してよいかどうか

- 生成コンテンツの社内外での利用ルール(誰がチェックし、どこまで自動化するか)

- 禁止事項(差別的発言の生成、違法行為の助長など)

- 利用ログやプロンプトの取り扱い

AIポリシーは、セキュリティ担当や法務だけでなく、現場利用者・人事・広報・経営層を巻き込みながら策定し、現実的で運用しやすいものにすることが重要です。

3-2. AIガバナンスを担う横断的なチームを組成する

AIプロジェクトは、特定部門だけでは完結しません。次のようなメンバーで構成されるAIガバナンス委員会・ワーキンググループを設けると、リスク管理とイノベーションの両立が進めやすくなります。

- 情報システム・セキュリティ担当

- 法務・コンプライアンス担当

- 事業部門(AIの主要ユーザー)

- データサイエンティスト・AIエンジニア

- 人事(スキル開発・評価制度を担う)

このチームが、ツール選定・リスク評価・利用ルール策定・教育・モニタリングを一元的にリードすることで、部門ごとのバラバラな導入を防ぎつつ、スピード感を持った展開が可能になります。

3-3. 「三つのライン」で役割分担を明確にする

AIリスク管理は、以下のように三つのラインに分けて考えると整理しやすくなります。

- 第一線(現場): AIツールを実際に使う担当者。プロンプト入力・結果の確認・業務への反映を担う。

- 第二線(管理部門): 情シス・セキュリティ・法務など。利用ルールの設計、ツールの許可/禁止、リスク評価を担う。

- 第三線(経営・監査): AI戦略の方向性決定、全社リスクのモニタリング、外部ステークホルダーへの説明責任を担う。

この役割分担を明確にし、誰がどこまで責任を持つのかを言語化しておくことが、トラブル発生時の対応スピードと透明性を高めます。

4. 安全なAI活用のための具体的なセキュリティ対策

ここからは、セキュリティ面での具体的な対策を見ていきます。全社一律に厳しい制限をかけるのではなく、業務の重要度やデータの機密性に応じて強度を調整することがポイントです。

4-1. データ分類と利用レベルの定義

まず、扱うデータを以下のように機密度レベルごとに分類し、それぞれに対して利用可能なAIツールと条件を決めます。

- 機密レベルA: 個人情報、営業機密、未発表の製品情報など。原則として外部サービスへの入力は禁止し、社内専用環境や専用モデルのみ使用。

- 機密レベルB: 社外非公開だが、限定されたパートナーとは共有可能な情報。利用可能なツールやログ管理の条件を明確化。

- 機密レベルC: 一般公開情報、既に社外に出ているコンテンツ。比較的自由に外部AIサービスを利用可能。

このようにレベル分けすることで、「すべて禁止」か「完全自由」の二択ではなく、リスクに応じた柔軟なAI活用が可能になります。

4-2. 安全なAIツール選定とアクセス管理

AIツールの選定では、単に機能や価格だけでなく、以下の観点での評価が不可欠です。

- データの保存場所・保存期間・暗号化の有無

- 入力データが学習に再利用されるかどうか(オプトアウトの可否)

- アクセス権限の細かさ(ユーザー単位・部署単位など)

- ログ閲覧・監査機能の有無

社内ポータルやSSO(シングルサインオン)と連携し、許可されたツールだけにアクセスできる環境を用意すると、シャドーAIの発生を抑制しやすくなります。

4-3. ログ監査とインシデント対応体制

AI利用時のプロンプト・出力・利用者情報のログを適切に記録し、一定期間保管することは、トラブル時の原因究明に欠かせません。また、以下の体制をあらかじめ整備しておくと安心です。

- 不適切な出力・情報漏えいの疑いを報告する窓口

- インシデント発生時の初動フロー(誰に連絡し、何を止め、どう検証するか)

- 定期的なログレビューと改善サイクル

重要なのは、「監視しているから使うな」ではなく、「問題が起きてもすぐに気付き、学習して改善できる仕組み」としてログを位置づけることです。

5. 倫理と透明性を確保するAIの設計と運用

AIの倫理と透明性を担保することは、長期的な信頼構築とレピュテーション保護に直結します。ここでは、現実的に取り組みやすいポイントに絞って整理します。

5-1. 利用者への開示と期待値調整

顧客向けサービスや社内システムにAIを組み込む場合、AIを利用していることを明示するとともに、その限界と前提条件を丁寧に伝えることが重要です。

- 「この回答はAIが自動生成しており、誤りを含む可能性があります」

- 「重要な判断は、必ず担当者による確認を行った上で実施してください」

こうした開示によって、AIへの過信を防ぎ、人間との適切な役割分担を保つことができます。

5-2. バイアスと差別のリスクを減らす

完全にバイアスのないAIを作ることは困難ですが、次のような取り組みによって、差別的な結果や誤用のリスクを減らすことができます。

- トレーニングデータやプロンプト設計の段階で、特定属性への不当に不利な扱いがないかを確認する

- 高リスクな用途(採用・与信・スコアリングなど)では、人によるダブルチェックを必須にする

- 不適切な表現を検知・ブロックするコンテンツフィルタを組み込む

特に、採用・人事評価・融資審査など、人の人生に大きな影響を与える領域では、AIを「参考情報」にとどめ、最終決定は人間が行う方針を徹底しましょう。

5-3. 説明可能性と検証可能性を高める

AIの出力結果に対して、「なぜその結論になったのか」をある程度説明できるようにしておくことも重要です。完全な説明が難しい場合でも、次のような工夫が有効です。

- 出力の根拠となる情報源や参照ドキュメントを提示する

- プロンプトと出力をセットで保存し、後から検証可能にする

- 重要なアルゴリズムやモデルのバージョンを管理し、変更履歴を残す

こうした取り組みは、社内監査や規制当局、顧客からの問い合わせに対して、透明性のある説明を行うための基盤になります。

6. イノベーションを加速させるための「攻めのAIリスク管理」

ここまで主に守りの観点を中心に解説してきましたが、AI組織のリスク管理は、単にリスクを抑えるだけでなく、イノベーションを加速させるための攻めの仕組みとして設計することが重要です。

6-1. 「サンドボックス環境」で安全に試す

AI活用のアイデアを素早く試しつつリスクを抑えるには、サンドボックス環境(検証専用環境)を用意するのが効果的です。

- 匿名化・ダミーデータを用いたプロトタイピング

- 限定メンバー・限定ユースケースでのパイロット運用

- 結果とリスクを評価した上で、本番環境への段階的展開

このような仕組みがあることで、現場は「とりあえず試してみる」ことができ、失敗から学ぶ文化が育ちやすくなります。

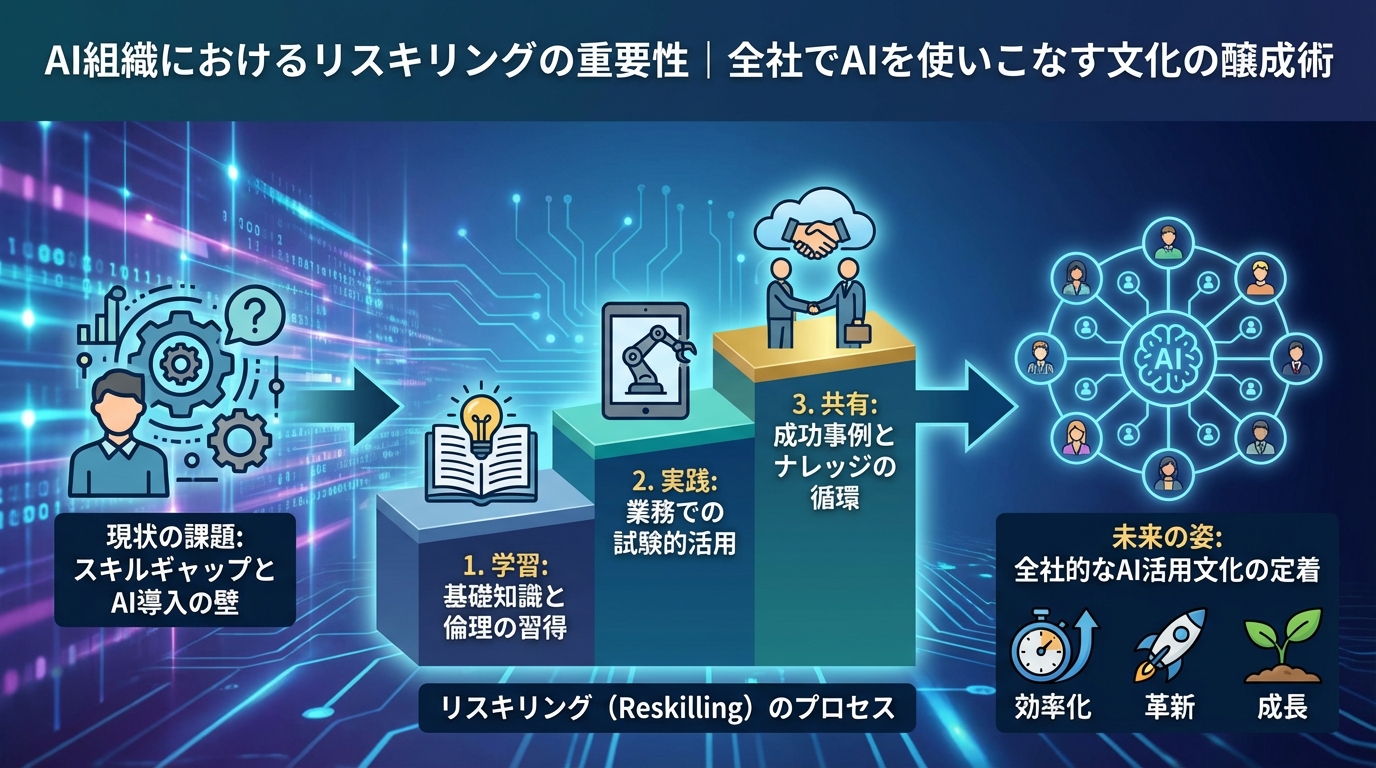

6-2. AIリテラシー向上と社内ナレッジ共有

AIのリスクは、技術そのものよりも、使い方や理解不足によって顕在化することが多いです。そのため、次のような取り組みによるAIリテラシー向上が、結果的にリスク低減とイノベーション加速の両方につながります。

- 職種別のAI研修(経営層向け・現場向け・技術者向けなど)

- プロンプトの書き方や活用事例を共有する社内ポータル

- 「AI相談窓口」や「AI活用コミュニティ」の設置

特に、現場で生まれた小さな成功事例を全社で共有し、「AIを使うと仕事が楽になる」「価値が出る」という実感を広げていくことが、AI文化の定着に大きく貢献します。

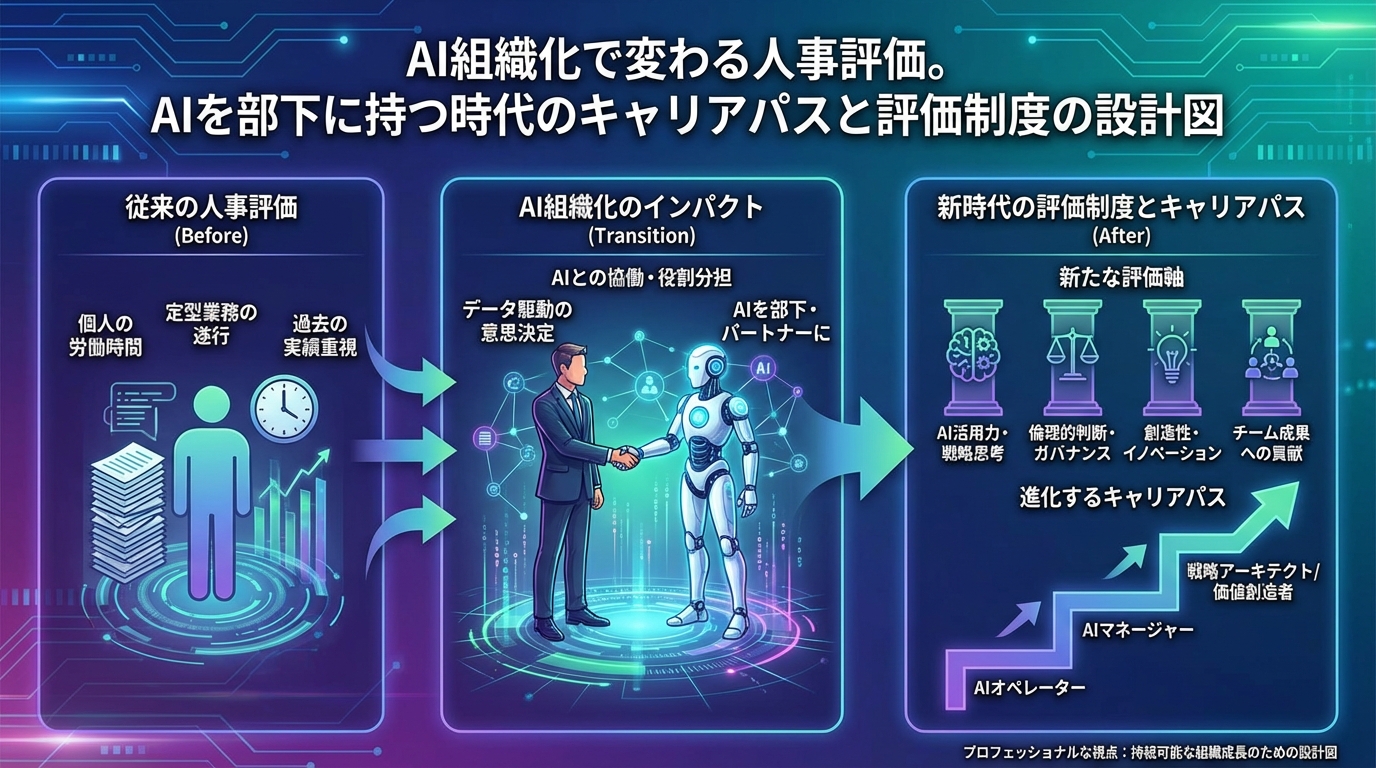

6-3. KPI設定と継続的な改善サイクル

AI組織のリスク管理がうまく機能しているかを測るためには、KPI(重要業績評価指標)を設定し、定期的にレビューすることが有効です。

- AIツールの利用率・利用部門数

- AI活用による工数削減・品質向上の実績

- AI関連のインシデント件数・重大度

- AIリテラシー研修の受講率・満足度

これらを定点観測し、「どこでリスクが高まっているか」「どの領域で投資対効果が出ているか」を把握しながら、ガバナンスとイノベーションのバランスを微調整していくことが重要です。

7. まとめ:AI組織のリスク管理術で、セキュリティ・倫理・イノベーションを同時に実現する

AI組織のリスク管理は、「制限すること」「禁止すること」が目的ではありません。

むしろ、セキュリティと倫理を土台として整えることで、安心してAIを活用し、イノベーションを継続的に生み出せる状態を作ることがゴールです。

この記事で紹介したポイントをあらためて整理します。

- AI導入では、「やらないリスク」と「やりすぎるリスク」の両方を意識する

- リスク領域(セキュリティ・プライバシー・倫理・品質・組織)を整理し、抜け漏れなく把握する

- AIポリシーやガバナンス体制を整え、全社的なルールと役割分担を明確にする

- データ分類・ツール選定・ログ管理など、具体的なセキュリティ対策を講じる

- 説明責任・バイアス対策・透明性の確保など、AI倫理の基本を押さえる

- サンドボックス・教育・ナレッジ共有により、攻めのAIリスク管理でイノベーションを加速させる

これらを一気に完璧に整える必要はありません。まずは、自社の現状と目指す姿を可視化し、小さく始めて継続的に改善していくことが何より大切です。

AI組織のリスク管理術を味方につけ、セキュリティと倫理を両立させながら、貴社ならではのAIイノベーションを加速させていきましょう。

ブログ一覧へ戻る

ブログ一覧へ戻る

LINEで無料相談

LINEで無料相談 お問い合わせ

お問い合わせ