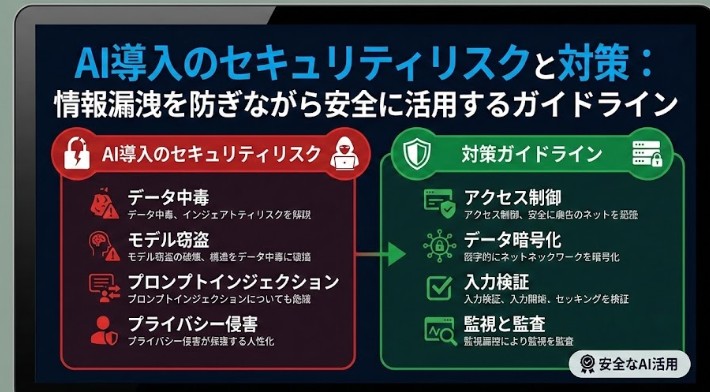

AI導入のセキュリティリスクと対策:情報漏洩を防ぎながら安全に活用するガイドライン

AI導入のセキュリティリスクと対策:情報漏洩を防ぎながら安全に活用するガイドライン

ChatGPTなどの生成AIや社内向けAIツールを業務に取り入れる企業が急増する一方で、「情報漏洩のリスクが怖くて本格導入に踏み切れない」という声も少なくありません。便利さと引き換えに、機密情報や個人情報が外部に流出してしまっては本末転倒です。

本記事では、AI導入を検討・推進する企業担当者や情報システム部門の方に向けて、AI導入に伴うセキュリティリスクと、その具体的な対策・社内ガイドラインの考え方を分かりやすく整理します。情報漏洩を防ぎながら、安全かつ効果的にAIを活用するための実務的なポイントを解説します。

1. なぜAI導入でセキュリティリスクが高まるのか

まず理解しておきたいのは、AIそのものが危険なのではなく、「AIにどのようなデータを渡し、どのような環境で利用するか」によってリスクが大きく変わるという点です。特にクラウド型の生成AIサービスは、インターネット越しに外部のサーバーへデータを送信する仕組みのため、従来の社内完結型システムとは前提が異なります。

AI導入時に考えるべきセキュリティの懸念点は、大きく分けて次の4つです。

- 情報漏洩(機密情報・個人情報の外部流出)

- データの取扱い・保存に関する不透明さ

- 生成されるコンテンツの正確性・信頼性

- コンプライアンス・法令違反のリスク

本記事では特に、情報漏洩リスクとその対策に焦点を当てて解説します。

2. AI導入における主なセキュリティリスク

2-1. 入力データからの情報漏洩リスク

生成AIを利用する際には、ユーザーがプロンプトとしてテキストやファイルを入力します。このとき、機密情報や個人情報を含んだまま入力してしまうと、次のようなリスクが発生します。

- AIサービス側の学習データとして保存・利用され、将来的に他ユーザーへの回答に影響する可能性

- 外部攻撃や内部不正により、サービス事業者側でデータが漏洩する可能性

- 規約やプライバシーポリシー上、想定外の用途に二次利用される可能性

一般的な公開型AIサービスは、「入力データをモデル改善に利用する」ことを利用規約に明記している場合があります。ビジネス用途で利用する際には、入力したデータがどこまで保存され、どのように使われるのかを必ず確認する必要があります。

2-2. 出力結果からの情報漏洩・誤情報リスク

AIが生成した回答の中に、本来公開すべきでない情報が含まれるケースもリスクになります。例えば、学習元データや過去の入力内容が不適切な形で出力されてしまう可能性、あるいは誤った情報を事実として利用してしまうリスクが考えられます。

また、社員がAIの回答をそのまま社外文書やWebサイトに掲載すると、著作権・コンプライアンス上の問題が発生することもあります。セキュリティだけでなく、情報ガバナンス全体の観点からルールを定めることが重要です。

2-3. シャドーIT化による統制不能リスク

社内で正式なルールやツールが整備されていない場合、社員が個人アカウントや無料版サービスを勝手に使い始めることがあります。これがいわゆる「シャドーIT」であり、情報システム部門が把握できないまま機密情報が外部のAIサービスに入力されるなど、極めて高いリスクを生みます。

AI活用を禁止するだけでは、業務効率化へのニーズを抑え込むことはできません。安全な利用方法を整えたうえで、組織として適切にコントロールすることが求められます。

2-4. モデル・インフラ自体への攻撃リスク

自社でAIモデルや学習基盤を構築する場合は、インフラへのサイバー攻撃や、モデルを狙った「敵対的攻撃(アドバーサリアルアタック)」なども考慮が必要です。

- APIキーの窃取や不正利用

- クラウド環境の設定ミスによる情報漏洩

- 推論APIへの過負荷攻撃(DDoSなど)

- 悪意ある入力によるモデルの挙動のねじ曲げ

こうした技術的リスクは、従来のWebシステムと共通する部分も多いため、既存のセキュリティ対策にAI特有の観点を加えていくことが重要です。

3. AI導入時に必ず押さえるべきセキュリティ対策の基本方針

AIのセキュリティ対策を検討する際は、細かい技術論に入る前に、まず次の3つの基本方針を明確にしておくとスムーズです。

3-1. 「入力してよい情報」と「入力してはいけない情報」を明確化する

最もシンプルかつ効果的な情報漏洩対策は、そもそもAIに機密情報を入力しないことです。そのために、以下のような区分を社内ルールとして明文化します。

- 絶対に入力禁止: 顧客の個人情報、社員の個人情報、未公開の経営情報、取引条件、契約書の原文データなど

- 原則禁止だが、専用環境なら可: 匿名化・マスキングを施したデータ、社内限定資料の一部 など

- 入力可能: 公開済みの自社情報、一般公開されている資料、学習用のサンプルデータ など

この線引きを明確にすると、現場の利用者も迷わずにAIを活用しやすくなります。

3-2. 利用目的と利用範囲を定義する

「何のためにAIを使うのか」が曖昧なままだと、想定外の用途で機密情報が利用されるリスクが高まります。例えば、次のような観点で利用目的と範囲を定義します。

- 文章要約・アイデア出し・プログラム補助など、許可する業務範囲

- 顧客対応メールのドラフト作成など、上長の確認を必須とする利用ケース

- 稟議書・契約書・見積条件など、AI利用を禁止する業務

こうした方針を事前に決めておくことで、リスクを抑えつつAIのメリットを享受できます。

3-3. 組織全体で統一したガイドラインを策定する

部署ごとにバラバラなルールでAIを使い始めると、全社としての統制が効かなくなります。情報システム部門やセキュリティ担当、法務、人事など関係部署が連携し、全社共通のAI利用ポリシー・ガイドラインを策定することが重要です。

ガイドラインには、利用目的・禁止事項・入力データのルール・ログ管理・教育・問い合わせ窓口などを含め、誰が読んでも分かる平易な言葉でまとめることがポイントです。

4. 具体的なセキュリティ対策と実務上のチェックポイント

4-1. 利用するAIサービス・基盤の選定

AI導入のセキュリティレベルは、どのサービス・プラットフォームを選ぶかで大きく変わります。選定時には、次のポイントを必ず確認しましょう。

- データの保存と学習利用の有無: 入力データが学習に利用されるか、保存期間はどれくらいか

- データの保存場所: データセンターの所在地(国内/海外)、リージョン選択が可能か

- 暗号化: 通信経路・保存データが暗号化されているか

- 認証・アクセス制御: シングルサインオン(SSO)、多要素認証(MFA)に対応しているか

- 監査ログ: 利用履歴や操作ログを取得・保存できるか

- 認証取得状況: ISO27001、SOC2など情報セキュリティ関連の認証の有無

機微なデータを扱う場合は、企業向けの専用プラン(エンタープライズ版)や、プライベート環境で動作するAI基盤を利用することが望ましいです。

4-2. データの匿名化・マスキング

どうしても業務上、実データに近い情報をAIに入力する必要がある場合は、匿名化・マスキングを徹底します。

- 氏名や住所、電話番号などの個人情報を伏字・記号に置き換える

- 企業名・取引先名を「A社」「B社」などに変える

- 金額や数量などの数値を、実際とは異なるサンプル値に置き換える

あらかじめテンプレートや変換ルールを用意し、誰が作業しても同じ基準で匿名化できる仕組みを整備することが重要です。

4-3. アクセス権限と認証の強化

AIツールや学習基盤にアクセスできるユーザーを必要最小限に絞り、権限管理を厳格に行います。

- ロールベースのアクセス制御(RBAC)を導入し、部署・役割ごとに権限を付与

- 機密性の高いデータセットへのアクセスは、承認制とする

- 管理者アカウントには多要素認証(MFA)を必須とする

また、退職者や部署異動者のアカウント・権限を速やかに見直す運用プロセスも欠かせません。

4-4. ログ管理とモニタリング

AIの利用状況を把握し、万一のインシデント発生時に原因を特定するためには、ログの取得・監視が重要です。

- 誰が・いつ・どのようなデータを入力し、どのような結果を取得したか

- 管理者による設定変更やデータアップロードの履歴

- 異常なアクセスや大量リクエストの検知

これらのログを、既存のSIEM(セキュリティ監視システム)や監査プロセスと連携させることで、AIを含めた一元的なセキュリティ管理が可能になります。

4-5. 利用者教育と社内コミュニケーション

どれだけ技術的なセキュリティ対策を講じても、最終的なリスクは「人」の行動に起因することが少なくありません。AI導入に際しては、利用者向けの教育と情報共有が不可欠です。

- AIに入力してはいけない情報の具体例を、実務に即して共有する

- 実際に起きた情報漏洩事例や、社内で想定されるリスクを紹介する

- 困ったときに相談できる窓口(情報システム部門・セキュリティ担当)を明示する

「禁止事項だけ」を伝えるのではなく、「安全な使い方」も併せて示すことで、現場の心理的ハードルを下げ、シャドーITの発生を防ぐことができます。

5. 安全なAI活用のための社内ガイドライン例

ここでは、実際にAI導入を進める企業が検討すべき、社内ガイドラインの構成例を紹介します。自社の業種・規模に合わせてカスタマイズして活用してください。

5-1. ガイドラインに盛り込むべき主な項目

- 目的

AI利用ガイドラインの目的と、企業としての基本的なスタンス(生産性向上とセキュリティ確保の両立など)を明示します。 - 適用範囲

対象となる部署・従業員、対象とするAIサービス・ツールの範囲を定義します。 - 利用目的と禁止事項

AIの想定利用シーンと、禁止される用途(機密情報の入力、差別的表現の生成依頼など)を具体的に記載します。 - 取扱い可能なデータの範囲

入力してよい情報・いけない情報の区分と事例を示します。 - アカウント管理とアクセス制御

アカウント発行・削除の手続き、権限付与のルール、多要素認証の利用などを明記します。 - ログ・監査

利用履歴の保存期間、監査の実施方法などを定めます。 - インシデント対応

情報漏洩などの疑いが発生した場合の報告フローと初動対応をまとめます。 - 教育・研修

新入社員や異動者への教育、定期的な研修の実施方針を示します。

5-2. 利用者向けの「チェックリスト」を用意する

分厚いガイドライン文書だけでは、忙しい現場のメンバーが読み込むのは難しいものです。そこで、日常利用の際にすぐ確認できる「チェックリスト」を用意しておくと効果的です。

例:

- この入力内容に、個人情報や機密情報は含まれていないか?

- このAIツールは、会社が許可した環境で利用しているか?

- AIの回答をそのまま社外に出さず、必ず自分の目で内容を確認したか?

こうしたシンプルな確認項目をポスターや社内ポータルに掲載し、日常的に意識できる仕掛けを作ることが重要です。

6. 自社導入パターン別:セキュリティ対策の考え方

AI導入の形態によって、セキュリティ対策のポイントは少しずつ異なります。代表的な3つのパターン別に見ていきましょう。

6-1. 公開型AIサービスのそのまま利用

例:一般向けChatGPT、Bingチャットなどをそのまま利用するケース。

この場合は、「入力データの制限」と「利用者教育」が特に重要です。機密情報は一切入力せず、業務ノウハウの整理や文章の言い換え、プログラムのサンプル作成など、比較的リスクの低い用途に限定します。

また、業務での利用を認める場合は、利用規約やプライバシーポリシーを確認したうえで、会社としての方針を明示しておく必要があります。

6-2. 企業向けクラウドAIサービスの利用

例:エンタープライズ向けの生成AIサービス、ビジネスチャットに統合されたAIアシスタントなど。

企業向けサービスでは、入力データを学習に利用しないオプションや、社内専用のテナント環境が提供されるケースが多くなっています。これらを活用することで、情報漏洩リスクを大きく低減できます。

一方で、アカウント管理・アクセス制御・ログ監査など、クラウドサービス全般に共通するセキュリティ運用が重要になります。自社のISMSやセキュリティポリシーと整合性を取りながら設計しましょう。

6-3. 社内オンプレミス/プライベートクラウドでのAI基盤構築

自社データをフルに活用した高度なAI活用を目指す企業では、社内オンプレミスやプライベートクラウド上にAI基盤を構築するケースも増えています。

この場合、データは基本的に社内ネットワーク内で完結するため、クラウド型サービスに比べて情報漏洩リスクを抑えやすい一方で、インフラ運用・モデル運用に関する高度なセキュリティ対策が求められます。

- サーバー・ネットワークのアクセス制御、脆弱性対策

- モデル・データセットへのアクセス権限管理

- バックアップと災害対策(BCP)

- 運用ログの収集・分析と、異常検知

自社だけで対応が難しい場合は、セキュリティに配慮したAI基盤構築を支援するベンダーと連携するのも有効です。

7. これからのAI時代に求められる「セキュリティと利活用の両立」

AI導入のセキュリティリスクを意識するあまり、「AIは危険だから使わない」という選択をしてしまうと、業務効率化や競争力向上の機会を逃してしまいます。一方で、十分な対策やルールなしにAIを使い始めると、情報漏洩やコンプライアンス違反といった重大なリスクに直面します。

重要なのは、リスクを正しく理解し、現実的な対策を講じたうえで、段階的にAI活用を広げていくことです。

- まずはリスクの高いデータを扱わない範囲で、小さく始める

- 利用状況と効果、課題を定期的に振り返り、ガイドラインをアップデートする

- 技術的対策と組織的対策(ルール・教育)を両輪で進める

AIは、適切に設計・運用すれば、セキュリティを損なうことなく業務生産性を大きく高める強力なツールとなります。本記事で紹介したリスクと対策、ガイドラインの考え方を参考に、自社に最適なAI活用の姿を具体的に描いてみてください。

8. まとめ:情報漏洩を防ぎながら安全にAIを導入するために

最後に、本記事の内容を簡潔にまとめます。

- AI導入のセキュリティリスクの中心は、入力データからの情報漏洩と、シャドーIT化による統制不能にある

- 「入力してよい情報/いけない情報」を明確に定めた社内ガイドラインの策定が不可欠

- AIサービス選定時には、データの保存・学習利用の有無や、暗号化・認証・ログ管理などの項目を必ず確認する

- 匿名化・マスキング、アクセス制御、ログ監査、利用者教育を組み合わせることで、情報漏洩リスクを大きく低減できる

- 公開型サービス、企業向けクラウド、社内AI基盤など、導入パターンに応じたセキュリティ設計が重要

AIのセキュリティリスクはゼロにはできませんが、適切な対策と運用によって十分にコントロールすることが可能です。情報漏洩を防ぎながら、安全かつ賢くAIを活用し、今後のビジネス競争力の源泉としていきましょう。

ブログ一覧へ戻る

ブログ一覧へ戻る

LINEで無料相談

LINEで無料相談 お問い合わせ

お問い合わせ