AI技術の進化に伴い、単一のAIモデルで完結するタスクは少なくなり、複数のAIモデルやサービスを組み合わせて、より複雑で高度なビジネスプロセスを実現するケースが増えています。この複雑なAIシステム群を効率的かつ確実に動作させるための鍵となるのが、「AIオーケストレーション」です。

本記事では、AIオーケストレーションの基本的な概念から、ビジネスで最大限の価値を引き出すための具体的な手順、そして成功に導くためのポイントを、SEOの専門家の視点から詳しく解説します。

1. AIオーケストレーションとは?

1-1. 定義と基本的な役割

AIオーケストレーション (AI Orchestration) とは、複数の独立したAIモデル、機械学習 (ML) サービス、データパイプライン、そしてビジネスロジックを統合し、一つのエンド・ツー・エンドのワークフローとして管理・実行するプロセス、技術、または仕組みのことです。

オーケストラ(管弦楽団)の指揮者に例えるとわかりやすいでしょう。指揮者がいなければ、各奏者(個々のAIモデル)はバラバラに演奏してしまいます。AIオーケストレーションは、この指揮者の役割を果たし、各コンポーネントが適切なタイミングで、適切なデータを処理し、最終的な目標を達成するために協力し合うことを保証します。

1-2. なぜAIオーケストレーションが必要なのか?

現代のAIソリューションは、もはや単なる推論エンジンではありません。

- 複雑なタスクの実現: 画像認識、自然言語処理、構造化データの分析など、異なる種類のAIモデルを段階的に連携させることで、高度な意思決定や自動化が可能になります。例:顧客からの問い合わせ(NLP) $\rightarrow$ 意図の分類 $\rightarrow$ 関連文書の検索 $\rightarrow$ 要約生成 $\rightarrow$ CRMへの記録。

- 効率性とスケーラビリティの向上: 各コンポーネントの実行順序、依存関係、リソースの割り当てを最適化し、ボトルネックを解消することで、システム全体の処理速度と効率を高めます。

- 信頼性と再現性の確保: エラー処理、リトライロジック、バージョン管理を一元的に行うことで、AIワークフローの実行の信頼性を高め、本番環境での予測可能な動作を保証します。

- リソースの最適化: 必要なリソース(CPU、GPU、メモリ)を動的に割り当て、不要になれば解放することで、クラウド費用の削減に寄与します。

1-3. 関連用語との違い

AIオーケストレーションを理解する上で、混同されがちな関連用語との違いを明確にしておきましょう。

| 用語 | 役割 | 焦点 |

| データパイプライン | データの移動、変換、ロード(ETL/ELT)を自動化する。 | データの流れ |

| MLOps | 機械学習モデルの開発、デプロイ、運用、監視のライフサイクル全体を自動化・管理する。 | モデルのライフサイクル |

| AIオーケストレーション | 複数のAI/MLモデル、データパイプライン、ビジネスロジックを統合し、ワークフロー全体の実行を管理する。 | ワークフローの実行と連携 |

AIオーケストレーションは、MLOpsの一部として、またはデータパイプラインの一部として組み込まれることもありますが、その主眼は「多様なコンポーネントの協調的な実行管理」にあります。

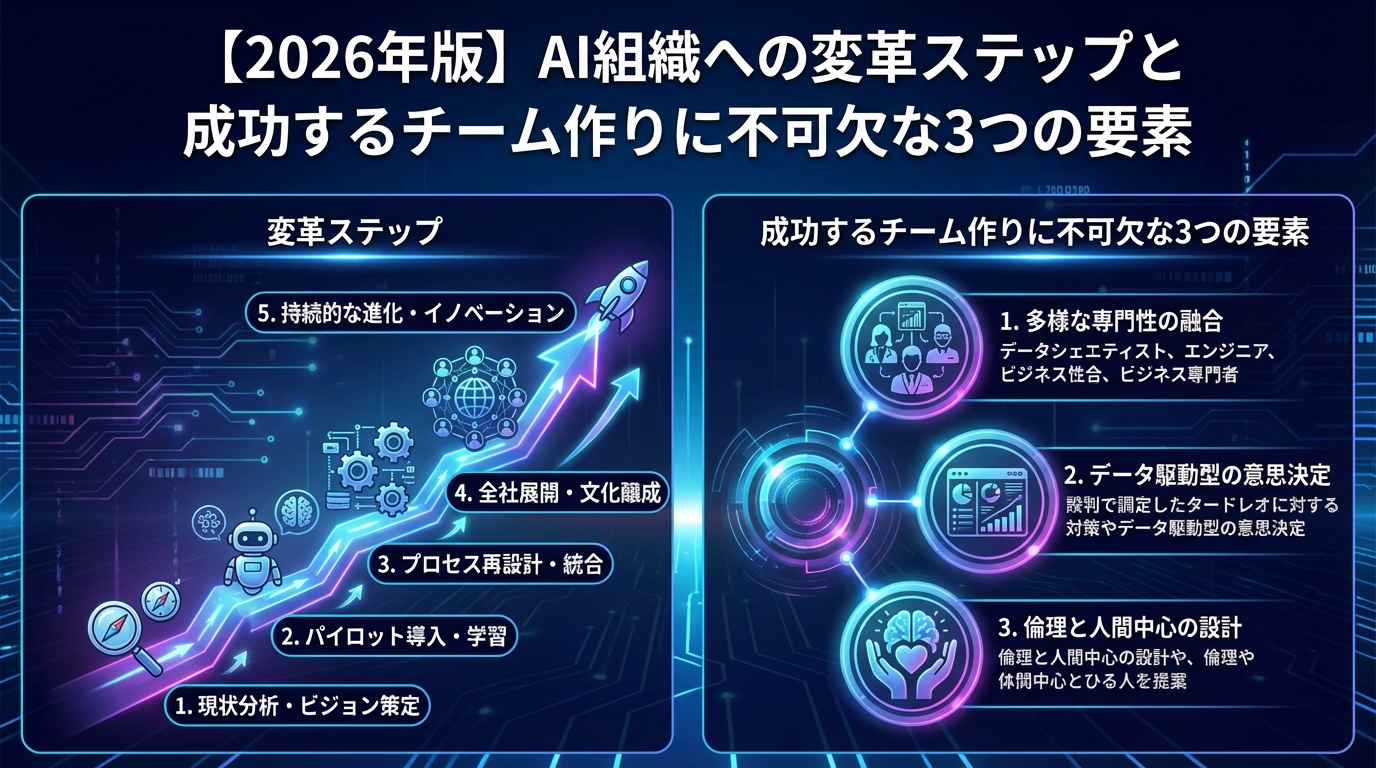

2. AIオーケストレーションのコア手順(5ステップ)

実際にAIワークフローを構築し、本番運用に乗せるための、具体的な5つのコア手順を解説します。この手順は、ビジネス要件の定義から継続的な改善までを網羅する、実践的なフレームワークです。

ステップ 1: ワークフローの設計と要件定義

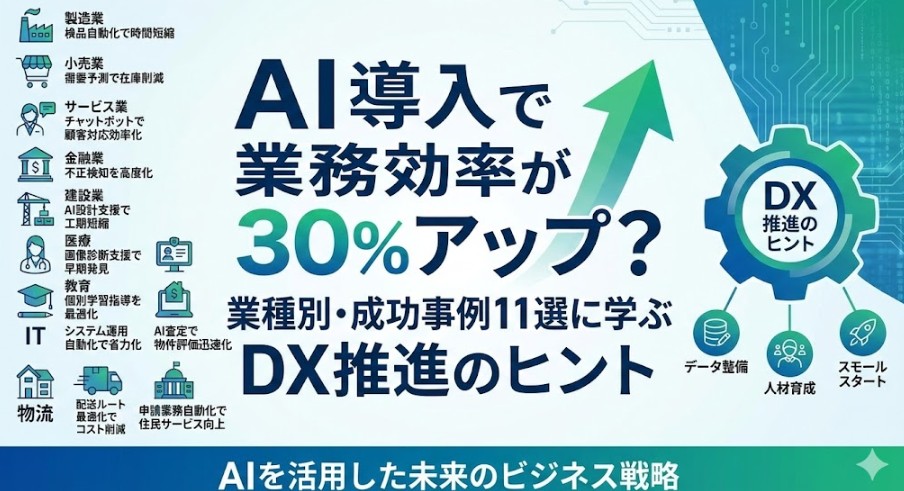

2-1. ビジネスゴールの明確化

AIオーケストレーションのプロジェクトは、解決したい具体的なビジネス課題から始める必要があります。「何のためにこのAIシステムを構築するのか?」という問いに明確に答えられるようにします。

- ゴール設定の例: 「顧客からのメール問い合わせ対応時間を平均10分から2分に短縮する」「製造ラインでの不良品検知率を95%以上に向上させる」

- 成功指標 (KPI) の設定: スループット、レイテンシ(応答時間)、精度、コストなど、最終的な成功を測るための定量的な指標を設定します。

2-2. コンポーネントの特定とワークフローの図式化

ビジネスゴールを達成するために必要な全コンポーネントを洗い出します。

- コンポーネントの例: データ取得モジュール (APIコール、データベース接続)、データ前処理 (Pandasなど)、AIモデル A (分類器)、AIモデル B (生成モデル)、後処理ロジック、結果出力先 (BIツール、Slack通知など)。

- 依存関係の定義: 各コンポーネントがどの入力に依存し、どの出力を作成するかを明確にします。フローチャートやグラフを用いて視覚化することで、ボトルネックや冗長なステップを特定しやすくなります。

ステップ 2: 開発環境の構築とコンポーネントの実装

2-3. オーケストレーションエンジンの選定

ワークフローを管理・実行するためのオーケストレーションツールを選定します。主要なツールには、以下のようなものがあります。

- Apache Airflow: 複雑な依存関係を持つバッチ処理に強く、Pythonでワークフロー(DAGs)を定義できる業界標準ツール。

- Kubeflow Pipelines: Kubernetes上で動作し、特にML実験やパイプラインの再現性、スケーラビリティに優れる。

- Azure Data Factory / AWS Step Functions / Google Cloud Composer: 各クラウドベンダーが提供するマネージドサービス。インフラ管理の手間が少ないのが利点。

2-4. コンポーネントの独立した実装とテスト

各AIモデルやデータ処理モジュールは、オーケストレーターから独立して呼び出し可能な形で実装します。一般的には、コンテナ技術(Docker) を使用してモジュールをパッケージ化し、どの環境でも一貫した実行を保証します。

- APIエンドポイント化: 推論サービスとしてモデルをデプロイし、オーケストレーターからはHTTPリクエストで呼び出す形式が一般的です(マイクロサービスアーキテクチャ)。

- 単体テスト: 各コンポーネントが設計通りの入力を受け取り、正確な出力を生成するかを個別にテストします。

ステップ 3: ワークフローの統合とテスト(パイロット実行)

3-1. ワークフロー(DAG)の定義

選定したオーケストレーションエンジンで、ステップ1で設計したフローチャートをコードとして定義します。AirflowであればDAG (Directed Acyclic Graph) として、ステップの実行順序、依存関係、エラー時の処理ロジックなどを記述します。

3-2. データと実行の整合性テスト

実際のデータフローを模擬した環境で、エンド・ツー・エンドのテストを実行します。

- データ検証: 各ステップで渡されるデータ形式が、次のステップの入力として正しく受け入れられるかを確認します(スキーマの整合性)。

- エラー処理テスト: 意図的にエラーを発生させ、リトライ回数、アラート通知、失敗時のフォールバック処理が設計通りに動作するかを検証します。

- 負荷テスト: 想定される本番環境のデータ量やリクエスト頻度で実行し、応答時間(レイテンシ)やスループットがKPIを満たしているかを確認します。

ステップ 4: デプロイと本番運用

4-1. インフラストラクチャの確立とデプロイ

開発環境で動作確認が取れたワークフローを、安定性と可用性の高い本番環境に移行します。

- コンテナオーケストレーション: Kubernetes (K8s) などのコンテナオーケストレーションプラットフォームを利用して、AIモデルやオーケストレーター自体をデプロイすることが主流です。

- IaC (Infrastructure as Code): TerraformやCloudFormationなどを用いて、インフラ設定をコード化し、再現性のあるデプロイを実現します。

4-2. 監視(モニタリング)とロギングの実装

本番環境でのAIワークフローの健全性を継続的にチェックするための仕組みを導入します。

- ワークフローの実行状況: どのステップが成功/失敗したか、実行時間がどれくらいか(Airflow UIなど)。

- システムのメトリクス: CPU/メモリ使用率、ネットワークトラフィック、ディスクI/Oなど、インフラ側の健全性。

- AIメトリクス: モデルの推論回数、精度、データドリフト(入力データの統計的特性の変化)など。

- アラートシステム: 失敗やパフォーマンスの低下を検知した場合、即座に担当者に通知する仕組み(Slack、PagerDutyなど)を設定します。

ステップ 5: パフォーマンスの評価と継続的改善

5-1. 定期的なレビューと評価

ステップ1で設定したKPIに基づき、本番稼働後のパフォーマンスを定期的にレビューします。

- ビジネス成果の検証: AIオーケストレーションの導入が、実際にビジネス目標達成に貢献しているか(例:問い合わせ時間が短縮されたか)。

- 技術的なボトルネックの特定: ワークフローの実行ログから、実行時間が長いステップや、リトライが多いステップを特定し、最適化の対象とします。

5-2. ワークフローの反復と最適化

特定された課題に基づき、ワークフローを改善します。これはMLOpsの「再学習と再デプロイ」のプロセスと密接に関連します。

- モデルの改善: 精度が低下したモデルを再学習・更新し、オーケストレーションパイプラインに新しいバージョンを組み込みます。

- コンポーネントの交換: より高性能なデータ処理ライブラリや、新しいAPIサービスにコンポーネントを置き換えます。

- リソースの調整: スケールアップ/スケールアウト(Pod数やインスタンスサイズの変更)により、レイテンシの改善を図ります。

3. AIオーケストレーションを成功させるための重要ポイント

AIオーケストレーションの真価を発揮するためには、技術的な手順だけでなく、設計思想と運用体制が重要になります。

3-1. 疎結合なコンポーネント設計 (Decoupling)

AIオーケストレーションの最大の利点は、柔軟性とメンテナンス性の向上です。これを実現するためには、各AIモデルや処理モジュールが疎結合であることが絶対条件です。

- 単一責任の原則: 各コンポーネントは、ワークフロー全体の中で一つの明確なタスクのみを担当すべきです(例:モデルAは分類のみ、モデルBはテキスト生成のみ)。

- インターフェースの標準化: コンポーネント間のデータのやり取り(インターフェース)は、JSONやProtobufなど、標準的で安定した形式を使用します。これにより、あるコンポーネントを別の技術スタックで実装された高性能なものに置き換えても、ワークフロー全体への影響を最小限に抑えられます。

3-2. 冪等性 (Idempotency) の確保

冪等性とは、「同じ操作を複数回実行しても、システムの状態が変化しないこと」を指します。AIオーケストレーションにおいては、エラーが発生して処理をリトライする際、この冪等性が極めて重要になります。

- リトライの安全性: データベースへの書き込みや外部APIへのリクエストを行うステップは、二重実行されても問題が発生しないように設計する必要があります(例:既に存在するレコードは更新のみ行う、一意のトランザクションIDを付与する)。

- 信頼性の基盤: 冪等性の確保は、複雑な分散システムであるAIオーケストレーションの信頼性と回復力(リカバリビリティ)の基盤となります。

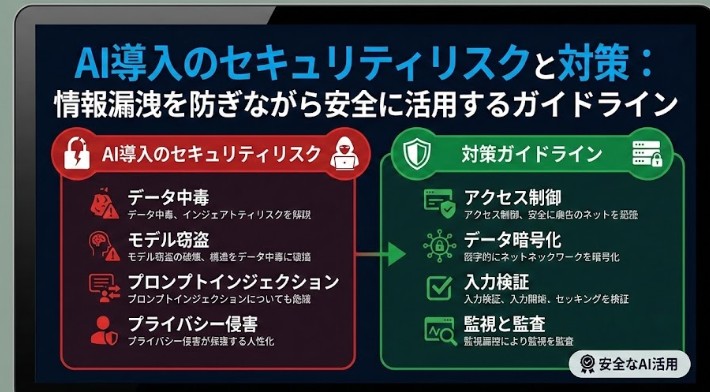

3-3. セキュリティとガバナンスの組み込み

AIワークフローは、機密性の高いデータや、重要なビジネスロジックを扱うため、セキュリティとガバナンスを設計段階から組み込む必要があります。

- アクセス管理: オーケストレーターや個々のコンポーネントが、必要なデータソースや外部サービスにのみアクセスできるように、最小権限の原則 (Principle of Least Privilege) に基づいたIAM (Identity and Access Management) ポリシーを設定します。

- データ保護: ワークフロー内の機密データは、転送中も保存時も暗号化 (Encryption) されていることを保証します。

- AIモデルのガバナンス: 使用するモデルのバージョン、トレーニングデータ、バイアス、法規制への準拠状況を追跡・記録します。

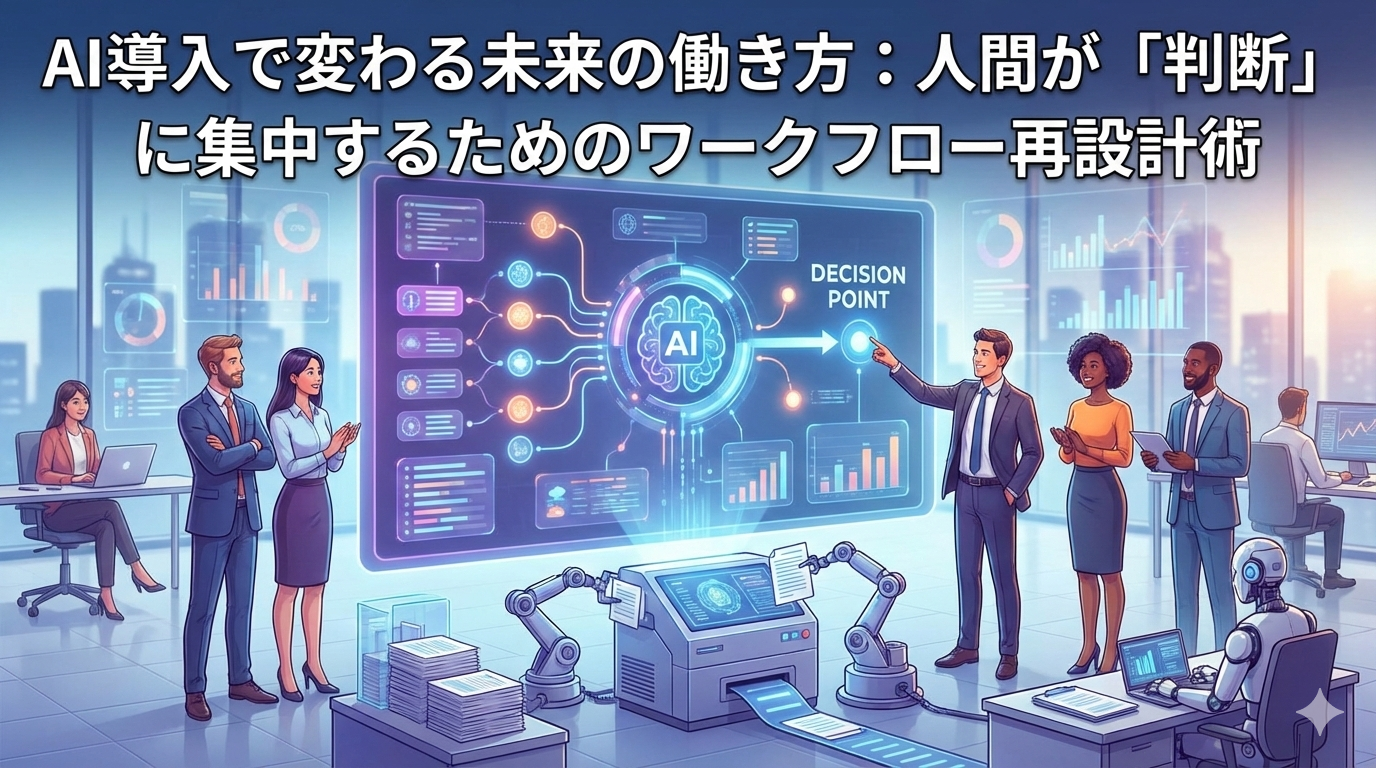

3-4. 人間による介入ポイントの設計 (Human-in-the-Loop)

完全自動化が理想ですが、特に初期段階や高リスクの意思決定においては、人間によるチェックや承認が必要な場合があります。

- 例外処理: AIの確信度が低い(Low Confidence)結果や、異常なデータフローを検知した場合、ワークフローを一時停止し、人間のオペレーターに通知して判断を委ねるステップ(Human-in-the-Loop、HITL)を組み込みます。

- フィードバックループ: 人間が修正した結果を、自動的にAIモデルの再学習データとして取り込むフィードバックループを設計することで、システム全体の継続的な精度向上を実現します。

4. AIオーケストレーションの未来と展望

AIオーケストレーションは、クラウドとエッジAIの普及、そして大規模言語モデル(LLM)の進化により、その重要性を増しています。

4-1. LLMを核としたオーケストレーションの進化

近年注目を集めるLLMは、従来の分類モデルや回帰モデルとは異なり、複数のタスクを処理できる汎用性が特徴です。

- エージェントとしてのLLM: LLMがワークフローの「意思決定者」となり、外部ツールや他のAIモデル(例:画像生成AI、特定ドメインの知識グラフ)を呼び出すAIエージェントを構築する動きが加速しています。このエージェント設計は、高度なAIオーケストレーションの一つの形態です。

- プロンプトとオーケストレーション: 従来のワークフローがコード(DAG)で定義されていたのに対し、今後はLLMへのプロンプトを通じてワークフロー全体が動的に生成・実行される、より柔軟なオーケストレーションへと発展していく可能性があります。

4-2. エッジとクラウドの連携

IoTデバイスや産業用センサーの普及により、AI処理の一部をデータ発生源の近く(エッジ)で行うケースが増えています。

- 分散オーケストレーション: エッジで実行される軽量なAIモデル(例:予備的な異常検知)と、クラウド上で実行される重厚なAIモデル(例:詳細な原因分析、再学習)を連携させ、全体として一つのワークフローとして機能させる分散型AIオーケストレーションの技術が重要になります。

📝 まとめ:AIオーケストレーションの成功は「設計」にあり

AIオーケストレーションは、単なるツールの導入ではなく、複雑なAIコンポーネント群をビジネス価値に変えるための「設計思想」です。

本記事で解説した以下のコア手順を踏まえ、堅牢でスケーラブルなAIワークフローを構築することで、企業はAI技術の可能性を最大限に引き出すことができます。

- ワークフローの設計と要件定義

- 開発環境の構築とコンポーネントの実装

- ワークフローの統合とテスト(パイロット実行)

- デプロイと本番運用

- パフォーマンスの評価と継続的改善

特に、疎結合なコンポーネント設計と冪等性の確保は、長期的な運用安定性の鍵となります。AIオーケストレーションをマスターし、貴社のデジタルトランスフォーメーション (DX) を加速させてください。

ブログ一覧へ戻る

ブログ一覧へ戻る

LINEで無料相談

LINEで無料相談 お問い合わせ

お問い合わせ